成本与速度的博弈:为您的CDN引入“智能缓存层”的架构指南

你是否也陷入了这个两难困境:为了追求极致的访问速度,不得不为CDN支付高昂的账单;而试图控制成本时,用户体验又立即发出警报?这看似无解的矛盾,其实源于一个被广泛忽视的架构盲点——我们默认了“CDN边缘节点”与“原始服务器”这种直连模式的不可挑战性。

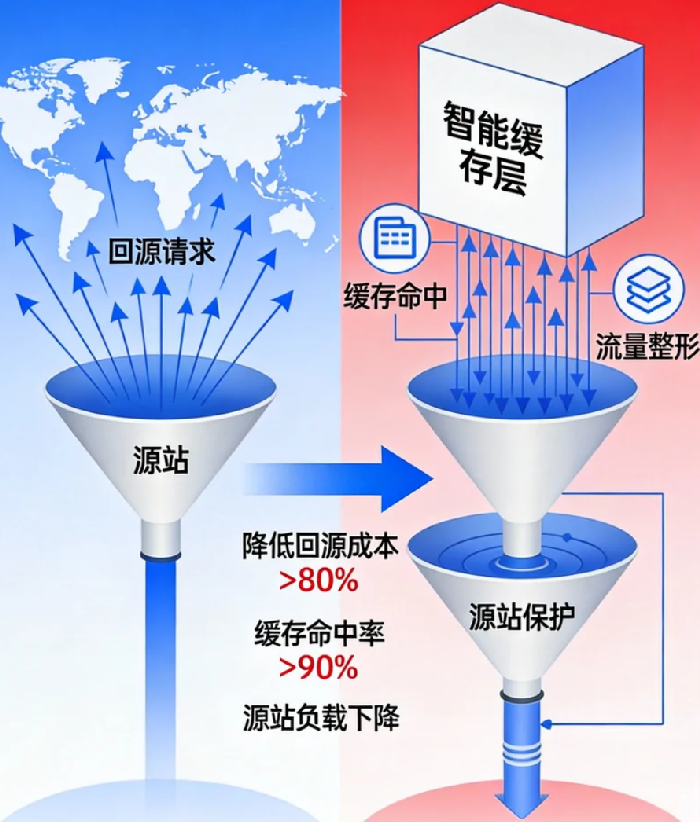

今天,我想和你探讨一个能从根本上打破这一僵局的架构思路:在CDN和你的源站之间,引入一个智能缓存层。这不仅仅是增加一层缓存那么简单,而是一次战略性的架构升级。它将你的内容分发网络,从一个简单的“传输管道”,重塑为一个具备全局调度与优化能力的智能分发系统。

让我们从一个反直觉的真相开始:在传统的CDN回源模式下,你的源站带宽可能是整个数字业务中单位成本最高、却效率最低的支出。当全球各地的CDN边缘节点各自独立地向你的源站请求同一份文件时,你不仅在为重复的跨国流量付费,还将宝贵的源站性能消耗在了本可避免的I/O操作上。

第一部分:传统架构的隐形成本与“回源风暴”

要理解智能缓存层的价值,我们首先需要为传统架构的痛点算一笔明白账。

1. 被重复计费的“源站带宽税”

假设你有一份10MB的热门产品视频,被部署在东京、法兰克福、硅谷的三个CDN节点请求。在传统架构下,你的源站需要将这10MB的数据分别传输三次,跨越不同的网络链路。这意味着,你为同一份内容,支付了高达30MB的源站出口带宽费用。如果有一千个边缘节点呢?这个成本的放大效应是指数级的。据真实案例分析,为热门内容支付的这种“重复回源带宽税”,可能占到企业总CDN相关支出的15%-30%。

2. 源站性能的“不可预测性消耗”

每一次回源请求,无论请求的内容是否相同,都会占用源站的连接数、CPU和磁盘I/O。在流量高峰期,尤其是遭遇热点事件时,全球边缘节点同时回源,极易引发“回源风暴”,导致源站负载激增、响应变慢,甚至宕机。此时,CDN的加速效果会瞬间归零,所有用户的请求都将直面这个不堪重负的源站。

3. 缓存效率的“地理孤岛”困境

传统CDN的缓存是“边缘自治”的。新加坡节点缓存的文件,圣保罗节点无法直接使用。这种隔离造成了巨大的缓存冗余和浪费,整体缓存资源利用率低下。你的热门内容需要在全球成百上千个节点上重复缓存,而你的长尾内容可能在任何节点都得不到有效的缓存。

智能缓存层的核心使命,就是在这条紧绷的“成本-速度”钢丝上,建立一个稳定的平衡支点。

第二部分:智能缓存层解构:它是什么,为何智能?

那么,这个智能缓存层究竟是什么?你可以将它理解为 CDN的“专用源站”或“全局共享缓存池”。它通常由具备强大I/O能力和弹性扩展的云对象存储(如AWS S3、阿里云OSS)或高性能缓存服务(如Redis云托管版)来构建,并部署在与你主源站相同或网络质量极佳的区域。

它的“智能”体现在三个关键机制上:

1. 全局去重与共享

这是其价值的核心。当东京的CDN节点首次请求一份文件时,它会回源到智能缓存层并将其缓存。随后,当法兰克福的节点请求同一份文件时,智能缓存层会识别出该文件已存在,并直接提供服务,而不会再向你的原始业务源站发起请求。这意味着,无论全球有多少个边缘节点需要同一份内容,你的原始源站最多只承担一次输出压力。这直接消除了“重复回源带宽税”。

2. 分层缓存策略

智能缓存层自身就是一个可配置、可管理的大型缓存。你可以为其设置比边缘节点更长的缓存时间(TTL),因为它不直接面对终端用户,无需担心缓存过期影响实时性。它成为了一个稳定的二级缓存,专门用于吸收和聚合来自全球边缘的回源流量,保护后方娇贵的原始应用服务器。

3. 流量整形与调度

智能缓存层可以对回源流量进行整形和排队,避免突发流量直接冲击源站。它就像一个大坝,将汹涌的洪水转化为平稳的溪流。同时,它还可以根据源站健康状态,实施智能降级或重试策略,提升整个分发链路的韧性。

引入这一层后,你的内容流向从混乱的“全球边缘 -> 单一源站”星型结构,变成了高效的“全球边缘 -> 智能缓存层 -> 源站”两级分层结构。成本与速度的博弈,从此有了一个可调控的中间变量。

第三部分:架构蓝图:如何构建你的智能缓存层?

理论令人振奋,落地需要蓝图。以下是构建智能缓存层的三种核心架构模式,你可以根据业务复杂度进行选择。

模式一:对象存储作为“唯一源站”(最简单直接)

做法:将所有的静态资源(图片、视频、JS/CSS库、下载包)直接上传至云对象存储,并将CDN的回源地址配置为该存储的地址。你的应用服务器彻底从静态资源服务中解放。

适用场景:静态网站、媒体内容平台、移动App资源分发。

优点:架构极简,成本可控,弹性无限,无需管理缓存策略。

注意事项:需要处理好文件更新后的CDN刷新(Purge)问题。

模式二:对象存储作为“缓存层”(推荐主流模式)

做法:CDN回源至智能缓存层(对象存储),而缓存层再回源到你的真实应用服务器。当缓存层没有命中时,它才会从应用服务器拉取并存储。

优点:同时支持静态资源和可缓存的动态内容(如API响应、个性化但非实时的页面片段)。为源站提供了强大保护。

关键配置:需要在智能缓存层(或通过CDN边缘逻辑)配置精细的缓存规则,决定什么内容可以缓存、缓存多久。

模式三:专用缓存服务作为“热点加速层”(高阶性能之选)

做法:在模式二的基础上,在智能缓存层与源站之间,再增加一层基于内存(如Redis)的极速缓存,专门用于缓存那些访问频率极高的“热点”数据。

适用场景:电商秒杀、新闻头条、票务系统开售等极端热点场景。

优点:能为热点数据提供近乎内存级的响应速度,彻底消化峰值流量。

成本:架构和运维复杂度最高。

对于大多数企业,从模式二开始实践是最平衡的选择。它不仅解决了静态资源问题,还为未来处理可缓存的动态内容打开了大门。

第四部分:核心策略:让缓存层真正“智能”起来

部署了基础设施,还需注入灵魂——策略。智能与否,取决于缓存策略的设计。

1. 缓存键(Cache Key)优化:避免“自己打自己”

这是提升命中率的第一要务。确保智能缓存层使用标准化、去除了无关参数的缓存键。例如,/image.jpg?width=300×tamp=12345 和 /image.jpg?width=300×tamp=67890 可能指向同一张图片,但因时间戳不同,会被视为两个不同对象,导致缓存命中率暴跌。你需要配置规则,忽略像 timestamp、uid 这类用于追踪但不影响内容的查询参数。

2. 分层TTL策略:在新鲜与效率间取得平衡

不要对所有内容使用单一的缓存时间。

智能缓存层 -> 源站:可以设置较长的TTL(如24小时),因为这里缓存的是“数据真相”,更新可以通过主动刷新(Purge)触发。

CDN边缘 -> 智能缓存层:可以设置较短的TTL(如1小时),这样能保证用户在一定时间内看到的内容相对新鲜,同时大幅降低回源频率。

实施“软过期+后台刷新”:当缓存即将过期时,智能层可以异步回源检查更新,在内容无变化时自动续期,避免用户请求等待。

3. 预热与淘汰:变被动为主动

主动预热:在大型活动(如新品发布、促销)开始前,提前将关键资源推送到智能缓存层乃至全球边缘节点。这能确保活动开始时,用户体验流畅,源站波澜不惊。

智能淘汰:采用LRU(最近最少使用)等算法,并结合成本分析,优先淘汰那些体积大、访问频率低的内容,让缓存空间始终服务于最高价值的资源。

第五部分:监控与度量:你的博弈赢了吗?

架构升级的成败,必须用数据衡量。你需要建立一套新的监控视角:

核心指标:

智能缓存层命中率:这是衡量其价值的最直接指标。目标应设定在90%以上。

源站带宽削减率:对比引入前后,源站出口带宽的下降比例。理想情况下,静态资源对应的带宽应下降80%-95%。

用户感知延迟(P95):关注用户从请求到获取内容的总耗时,确保架构优化没有引入新的延迟。

成本监控:

分别计算CDN流量、智能缓存层存储与请求、源站带宽三者的成本变化。你会发现,虽然增加了智能缓存层的成本,但源站带宽和因源站性能不足导致的扩容成本会大幅下降,总拥有成本(TCO)通常显著优化。

这场成本与速度的博弈,其最终目标并非让一方彻底战胜另一方。而是通过引入智能缓存层这个巧妙的架构变量,我们将一场零和游戏,转变为可以协同优化的双赢局面。它让你不再需要在“昂贵的快”和“廉价的慢”之间做痛苦抉择,而是能够用更合理的成本,架构出一个更快速、更稳定、更具韧性的全球内容分发系统。

当你看到源站的监控曲线变得前所未有的平稳,而CDN账单的增长开始与业务增长理性挂钩时,你会明白,这次架构升级带来的不仅仅是性能提升或成本节约,更是一种对数字业务基础设施的从容掌控感。这,或许是技术决策者能获得的最美妙的回报之一。