你有没有经历过这种情况:网站接了 CDN,本以为天下太平,结果某个地区访问突然变慢,用户反馈网页打不开,一查才发现——CDN 提供商某个节点挂了。而更讽刺的是,你的源站好好的,只是“边缘”塌了。

再升级一点:你用了某大厂的全球加速,说是 SLA 99.9%,可一旦发生大规模运营商劫持、DNS 投毒、国际链路抖动,你能做的只有等待。而你的网站——正在用户的刷新和愤怒中被“钝刀割肉”。

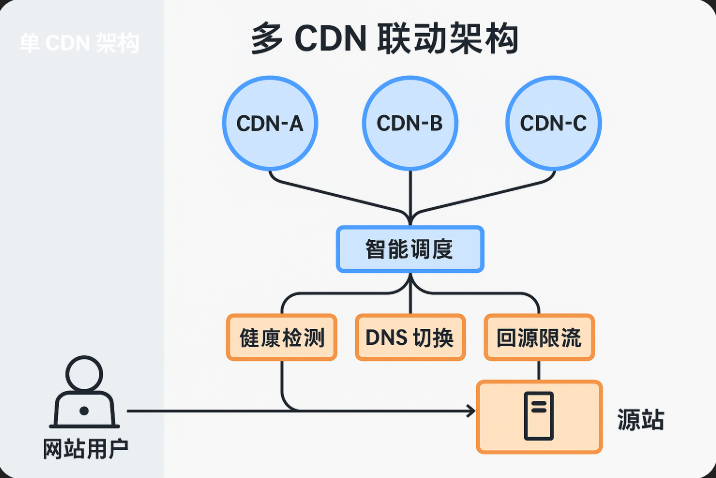

这就是为什么我们要谈“多 CDN 联动架构”:不是因为不信任任何一家 CDN,而是因为你没法完全依赖任何一家。

CDN 不可靠?不,是“单点”架构不可靠

CDN 是一种加速机制没错,但它本质上是一个“服务链路”中的关键节点——它能加速,但也能卡顿;它能抗压,但也可能故障;它能提升体验,但也能成为单点失败的起点。

举个形象点的例子:

CDN 就像你雇的快递员。你雇了一个顺丰,服务确实快,但如果顺丰今天罢工,你整个发货链条就断了。

那怎么办?换顺丰?用京东?还是自己送?最聪明的做法是:多平台联动,按地区、按状况做“动态调度”。

这,就是我们今天要聊的主角:“多 CDN 联动架构”。

一、为什么单 CDN 架构无法满足现代站点需求?

先别急着谈方案,搞清楚为什么“只接一个 CDN”不够用,是构建多 CDN 的第一步。

1.1 全球用户分布与不同 CDN 的地域强弱

没有任何一家 CDN 能在全球每个角落都保持最优响应。举个例子:

国内访问:腾讯云、阿里云、百度云 CDN 延迟表现不错;

东南亚:Cloudflare、QUIC.cloud 在新加坡、印尼部署更多;

北美或欧洲:Akamai、CloudFront 覆盖全面;

某些非洲国家:只有部分运营商 CDN 通得过。

如果你的网站有海外用户,仅靠一个 CDN,访问体验会不稳定,甚至“看脸”。

1.2 大厂故障不是传说

你可能听过这些真实案例:

某国内主流 CDN 大厂一次配置推送失误,导致全国多个节点 HTTP 504;

某国际厂商 Cloudflare 因 BGP 路由异常,全网出现间歇性连接失败;

某 CDN 免费计划用户被封 IP,影响所有同源的访问请求。

这些故障并不常见,但一旦发生,影响就不是“小概率”了,而是“全局性灾难”。

1.3 防攻击、防劫持、灾备需求日益强烈

攻击者也懂 CDN。他们会绕 CDN 直接攻击源站、利用 DNS 污染打 CDN 节点。而你唯一的对策就是“多线部署 + 多平台切换”。

而在政策合规和关键业务保障下,有些企业甚至需要“多活部署”——这时候,没有多 CDN 联动是很难保障业务不间断运行的。

二、多 CDN 联动的核心目标是什么?

说白了就三件事:

提升可用性(节点故障自动切换,不影响访问)

提升性能(按地域使用响应速度最优的 CDN)

提升控制力(不被某一家 CDN 限制绑死,有独立调度权)

一句话概括:不把鸡蛋放在一个篮子里。

三、从“单点接入”走向“联动架构”的技术演进路线

下面我们进入实操部分。要构建多 CDN 联动的边缘架构,需要从四个维度来拆解设计:

3.1 域名调度逻辑:DNS 轮询不是答案

你可能想当然:那我把域名搞个多 A 记录轮询,让用户自己“试一试”。

但这存在两个问题:

用户解析是不可控的,DNS 缓存存在“命中即黏住”的问题;

有些用户并不会自动重试“第二个 IP”,而是直接挂掉。

更靠谱的做法是:使用智能 DNS 或 全权解析服务(如 NS1、腾讯云 HTTPDNS),根据以下规则分配访问路径:

按地域:国内分配国内节点,海外分配对应 CDN;

按运营商:移动访问优选 CDN-A,电信访问 CDN-B;

按健康检测:某 CDN 响应慢则自动切换备用。

3.2 CDN 配置一致化管理

当你开始维护两三个 CDN 时,你会发现一件事:每家 CDN 的规则配置格式都不一样!

例如:

缓存规则(是否忽略参数、分路径设置)

回源配置(IP vs 域名、回源 Host)

HTTPS 强制、HSTS 配置差异

解决这个问题的方法有两个:

自建一个中间层配置平台,统一管理下发;

或者使用云端 API 工具(例如 Cloudflare API、Akamai Property Manager),自动化同步配置。

别手动同步配置,一改规则全靠记忆,这是灾难的种子。

3.3 边缘节点健康检测与切流机制

仅有多 CDN 不代表你有了“自动切换”能力。

你需要一个能持续监控各 CDN 边缘状态的系统,例如:

每 10 秒 ping 一次每家 CDN 节点;

请求关键资源的 TTL、错误率、流量变化;

判断是否需要“切流”或“熔断”。

这可以通过:

阿里云全站加速 + HTTPDNS + 自研 health-check

或者 Cloudflare Workers + Edge Health API

一旦某节点异常,通过 DNS 解析权,或 CNAME 改写规则将流量导向健康路径。

3.4 源站抗压与协议兼容性设计

别以为 CDN 把压力都吃了,多 CDN 的另一个挑战是源站要“接得住”。

CDN 联动意味着:多个回源节点、多个带缓存层的网络,源站要处理多种回源逻辑。

你要确保:

源站支持多个回源 IP,配置合理的白名单;

针对不同 CDN 回源策略(带 cookie、不带 token)配置接口兼容处理;

异常回源时返回标准状态码,避免缓存污染。

否则,多 CDN 没提升性能,反而把源站整崩了。

四、常见部署模型参考

为了让你更具体理解多 CDN 的落地方式,这里给出三种主流部署模型供参考:

模型一:主备式 CDN 切换

主 CDN 提供常规加速服务;

备 CDN 配置为“热备”,DNS TTL 设置低;

一旦主 CDN 健康检测失败,切换域名至备 CDN。

优点:实现简单,稳定性强;

缺点:切换有延迟,备份 CDN 长时间空转。

模型二:按地域智能分流

国内使用腾讯云 CDN,海外用 Cloudflare;

DNS 或边缘代理控制“用户-入口”的智能分配;

各自维持独立加速逻辑。

优点:提升访问体验;

缺点:配置复杂、数据分析分散。

模型三:链式 CDN 混合回源

一层边缘缓存:Cloudflare;

二层强缓存 CDN:阿里云;

源站统一托管于自建节点;

Cloudflare 缓存穿透后到阿里云,再到源站。

优点:高缓存命中率,层层分压;

缺点:调试困难,缓存链复杂,容易错位。

五、实践经验与踩坑警示

如果你准备落地多 CDN 架构,下面这些坑必须提前规避:

别忽视 DNS 缓存时间:TTL 太长会导致切换不及时;

注意证书配置差异:各 CDN 支持 SSL 类型不同,需提前准备;

定期回源测试:CDN 缓存容易让你“错觉一切正常”,定时绕过缓存访问源站,才能发现真问题;

CDN 日志收集一致化:用于分析回源流量、判断命中率;

不要混用同源资源跨 CDN:可能产生缓存污染和混乱 CORS 问题。

结尾,不是结论,而是提醒

很多人做网站加速走到最后,会陷入两个极端:

一种是“我全靠 CDN”,出了问题找服务商背锅;

另一种是“我 CDN 全弃用,全靠源站撑”,却被现实打脸。

其实,这两种思路都少了“系统性设计”的思维。

多 CDN 架构不是“炫技”,而是你业务需要稳定、容灾、扩展时的战略工具。

你要做的,不是“接几个服务商”,而是建立一个可观测、可控制、可切换的边缘网络系统。

因为最终的问题从来不是“有没有 CDN”,而是——你的架构能不能抗住真实世界的复杂性。